Generativ AI – från ööh? till AHA!

Ingen har nog missat the new cool kid in town – Generativ AI – som senaste tiden svept in som en storm. Men hur funkar det och vad betyder alla begrepp? Det är lätt att inte bara känna sig förvirrad av alla buzzwords utan också ge upp i att försöka förstå…

Men det ska vi inte göra! Nej, vi ska istället försöka prata på ett sätt där tekniken inte ställer sig i vägen för övergripande förståelse och nyfikenhet. Om jag lyckas återstår att se, men för dig som pallar att ta dig igenom all teori väntar en belöning i slutet 🍿.

Innan vi går in på den generativa AI-hypen, låt oss först reda ut några grundläggande saker.

Basic stuff

AI är långt ifrån någonting nytt. Idén om maskiners intelligens anses ha funnits sedan åtminstone 1940-talet och själva begreppet artificiell intelligens myntades på en konferens 1956. Men det är först de allra senaste åren som tekniken på allvar har börjat uppnå verklig höjd – både i innovationsgrad och hur högt våra ögonbryn lyfts av häpnad. Uppnått plötslighet.

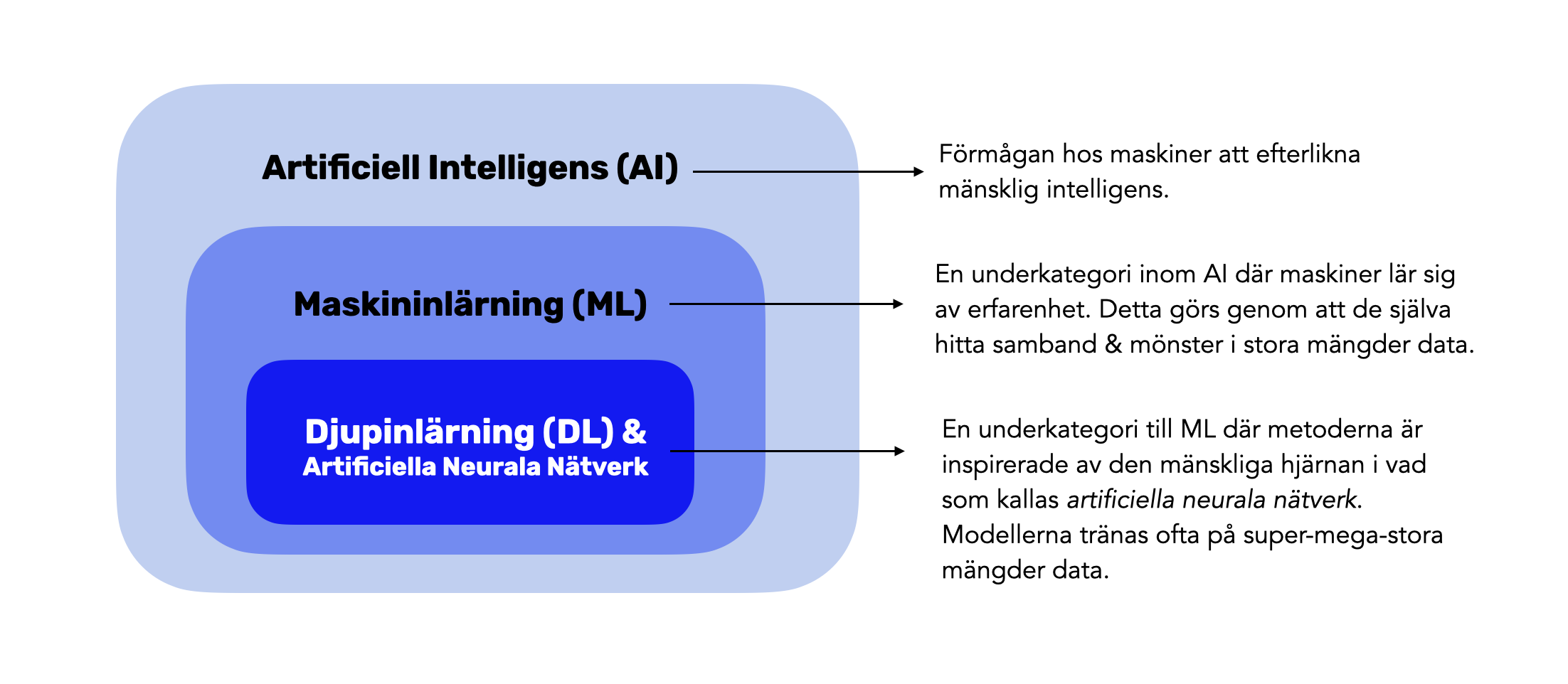

Begreppet AI är idag paraplynamnet för olika sätt där maskiner kan utföra saker som normalt kräver mänsklig intelligens.

Men!

När vi år 2023 imponeras av AI:s allt mer häpnadsväckande förmågor är det de mer avancerade underkategorierna djupinlärning (DL) & neurala nätverk som har varit i farten.

Vad är då Generativ AI?

Det som är nytt sedan ett par år är att AI (med hjälp av djupinlärning & neurala nätverk) har börjat skapa riktigt imponerande innehåll. Men inte bara det, utan också generera helt unikt innehåll som inte har funnits tidigare.

Innan Generativ AI har smarta algoritmer framför allt använts för saker som analys, optimering, automatisering och filtrering. Nu kan tekniken blixtsnabbt också skapa sådant som:

- Text: Författa texter, sammanfatta böcker och besvara våra frågor. Du har garanterat testat tjänster som ChatGPT eller Google Bard.

- Bild: Generera kreativa och högkvalitativa bilder. Midjourney, DALL·E ch Stable Diffusion är några exempel.

- Kod: Generera programmerad kod med hjälp av lösningar som GitHub Copilot eller Amazon CodeWhisperer.

Generativ AI kan också producera ljud, komponera musik, förvandla 2D till 3D, producera filmer och en massa mer.

Men stor sannolikhet kommer åren 2022 och 2023 att gå till AI-historien som brytpunkter där Generativ AI förändrade spelreglerna när det kommer till innehållsskapande. Och på sikt även en massa andra saker.

Fint. Då vet vi vad Generativ AI är. Låt oss nu unna oss lite glassigt nörderi.

Byggstenarna för Generativ AI

Inför skrivandet av den här artikeln har jag försökt att hitta en pedagogisk överblicksbild som sätter byggstenarna för Generativ AI i något greppbart perspektiv. Det har inte gått något vidare. Dels är de flesta alleles för tech-detaljerade (och ser ut såhär eller såhär). Och dels är de ofta oerhört tråkiga.

Så, med hjälp av Midjourney och ett enkelt designprogram tog jag fram en egen lite mer kreativ förklaringsmodell baserad på glass (hey, vem gillar inte efterrätt!). Resten av den här texten kommer nu att handla om själva struten i modellen. En strut som är grunden för att all Generativ AI både funkar och totalt exploderar just nu.

👋🏼 Säg hej till Foundation Models, LLMs, Transformers och Diffusion Models.

Låt oss ta dem en i taget.

➡️ Foundation Models

Foundation Models – grundmodell på svenska – är en superviktig anledning till att Generativ AI har exploderat så snabbt. Börja med att kolla igenom videon här under (den är bara på två minuter) för att greppa vad dessa grundmodeller fyller för funktion. Videon kommer från Stanford University Human-Centered AI och går också in på möjligheterna och riskerna som följer med dessa disruptiva Foundation Models.

För att träna upp en Foundation Model krävs bland annat djup kompetens inom maskininlärning, mattematik och statistik. Det behövs en massa kraftiga datorer, oerhörda mängder data och ofta jättemycket pengar. Inte så konstigt då att många av de större grundmodeller som finns där ute har utvecklats av välkända bolag som Google, Meta, IBM och OpenAI.

Den som vill bygga en egen Generativ AI-lösning behöver, tack vare Foundation Models, inte göra grovjobbet själv. Istället kan man använda sig av någon/några av de hundratals grundmodeller som finns och sedan anpassa dessa efter hur man vill att den egna lösningen ska funka.

Överkurs:

- Foundation models tränas upp med hjälp av enormt stora datamängder och via self-supervised learning och/eller semi-supervised learning.

- För att få en Foundation Model att bete sig som man vill finns det olika sätt att anpassa modellen. Dels genom vad som kallas för Fine-Tuning (man "finputsar" en redan tränad modell med hjälp av ny data som är anpassad för en specifik uppgift) eller genom vad som kallas för Prompt Tuning (en lättare form av anpassning där man genom prompts styr modellens beteende).

- Det finns både grundmodeller som är kontrollerade av företag (exempelvis GPT-4 utvecklad av OpenAI) och som är open source (exempelvis LLaMA2 utvecklad av Meta & Microsoft). I artikeln Making foundation models accessible: The battle between closed and open source AI kan du läsa mer om skillnaderna.

➡️ LLMs

LLM står för Large Language Model och är en typ av Foundation Model / grundmodell som har med språk och siffror att göra. När du använder ChatGPT eller Googles BARD är det en LLM som gör att det funkar.

I videon här under förklarar Nikita Namjoshi och Dale Markowitz från Google vad en LLM är.

Överkurs:

Vill du imponera på en kompis kan du droppa följande:

- Den senaste LLM-modellen som får ChatGPT att funka heter GPT-4

- Googles senaste LLM-modell som bland annat får BARD att funka är döpt till PaLM2.

- Den LLM-modell som Meta och Microsoft tillsammans har tagit fram heter LLaMA2.

Om du var uppmärksam när du kollade på LLM-videon hörde du begreppet “Transformers”. Det är nu dags att träffa de verkliga superstjärnorna inom Generativ AI.

➡️ Transformers

Transformers är namnet på en specifik modell eller metod inom djupinlärning som används som byggsten inom mycket som har med Generativ AI att göra.

“Transformers are considered a key, if not THE key, component to the new wave of Generative AI" - citat

Transformers är en av de viktigaste anledningarna till att Foundation Models och LLMs har blivit så imponerande. Det är bland annat Transformers som används för att träna GPT-4 som är LLM:en för ChatGPT.

"Vad sjutton? Vad då modeller och metoder??? Jag fattar inte", kanske du tänker.

Barnsligt mycket förenklat är Transformers ett smartare sätt att knäcka nöten intelligens. Vad nu intelligens är & vem som egentligen är smartast...

Överkurs:

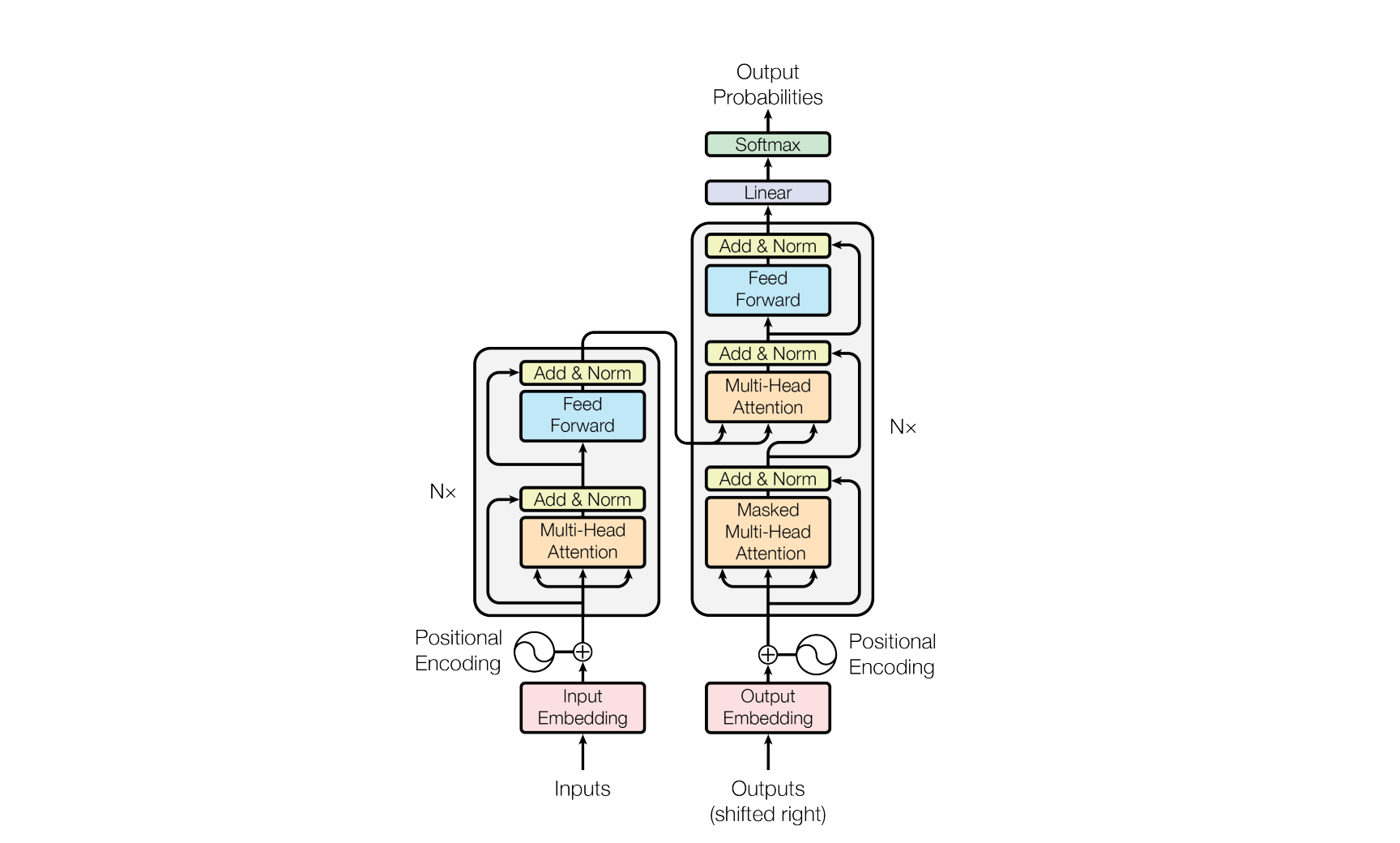

- Transformers introducerades för första gången av forskare på Google 2017 i artikeln Attention Is All You Need. & i bilden här under visualiserar forskarna hur en Transformer funkar. Rena grekiskan för de flesta som inte jobbar med att utveckla AI-lösningar. Nu har du i alla fall sett den!

- Om du inte vill läsa en superteknisk PDF (den från Google ovan) men ändå vill lära dig lite mer om Transformers kan jag tipsa om den här videon från IBM. Där går man in på överkursgrejer som Encoders, Decoders och Attention.

För dig som fortfarande läser, snyggt jobbat! Nu ska vi bara reda ut ett sista begrepp.

➡️ Diffusion Models

Det som Generativ AI blir allt vassare på är att generera verklighetstrogna bilder. Du har säkert testat tjänster som DALL·E från Open AI, Midjourney (min egen favvo) eller Stable Diffusion.

När det kommer till visuell AI är det inte bara Transformers som har varit i farten utan ytterligare en ny AI-stjärna som har utvecklats parallellt, nämligen Diffusion Models. I videon här under får du begreppet förklarat på 4 olika nivåer, från basic till mer avancerat.

Överkurs:

- Innan Diffusion Models gjorde entré användes andra modeller med namn som Generative Adversarial Networks (GANs), Variational Autoencoders (VAE) och Flow-based models.

Wohooooo!!! 🦾

Där var du igenom all tung teori. Låt oss snabbt repetera.

- Generativ AI är paraplynamnet för en ny våg av AI som kan skapa unikt innehåll.

- Foundation Models är grundmodeller som är upplärda på MASSOR med data. Och som man kan använda som grund för att bygga nya appar och lösningar inom Generativ AI.

- LLMs är en typ av Foundation Model och som har med text och siffror att göra.

- Transformers är ⭐️-modellen (men det finns fler) för att träna upp Generativa AI-modeller på text och siffror.

- Diffusion Models är ⭐️-modellen (men det finns fler) för att träna upp Generativa AI-modeller på sådant som har med visuellt innehåll att göra.

Och slår vi samman allt detta, ja då har vi grunden för det som får Generativ AI att funka. Vi får själva struten.

Men själva glassen med alla olika smaker då? Alltså, alla nya appar och tjänster som poppar upp varje dag och som vi kan använda. Ja, det får vi ta en annan gång (men den skulle kunna se ut något i stil med såhär ⬇️).

Efter denna sockerchock har du kanske fått 8 minuters extra energi att kolla på videon här under där Kate Soule från IBM sammanfattar en hel av det vi har pratat om. Men du kan också hoppa ner till nästa rubrik där belöningen väntar.

Förmodligen årets bästa AI-dragning 🥳

Nu har vi äntligen kommit till slutet och till belöningen!

I slutet av juli publicerad Spotify en SJUKT bra och pedagogisk video där Gustav Söderström – Co-President, CPO & CTO på Spotify – föreläser om AI på ett internt event. Tursamt nog för oss alla har den även lagts ut publikt både som Video-podcast (Spotify) och på YouTube!

Är det något på temat AI som jag kan rekommendera att kika på så är det just detta. Presentationen har fått mycket cred så kanske har du redan sett den.

I Gustavs dragning kommer du att känna igen och lära dig mer om de begrepp som vi har gått igenom i texten ovan. Så bänka dig framför valfri skärm och enjoy 1,30 h lärorik presentation 🍿 och kom ut på andra sidan som en uppgraderad 2023-människa.

Ytterligare tips

För dig som vill dyka ner ytterligare i den Generativa AI:ns värld kan jag rekommendera följande:

- The Future Of Generative AI Beyond ChatGPT, Forbes

- What’s the Future for A.I.?, The New York Times

- How Generative AI Is Changing Creative Work, Harvard Business Review

- What is generative AI?, McKinsey & Company

- AI-paradoxen – både vårt största hopp och ett potentiellt megahot (by me)

- AI ger oss innovation med superkrafter. Vad vi kan förvänta oss 2023 och framåt (by me)

På återhörande!

/ Judith

Prenumerera gärna på mitt nyhetsbrev Plötsligt i Framtiden på SubStack där jag en gång i veckan skriver artiklar och sammanställer nyheter inom teknik, hållbarhet och framtid.