Glassmodellen för Generativ AI – del 2

Generativ AI är bland det hetaste inom tech just nu, men också bland det svåraste att greppa rent tekniskt. För ett par veckor sedan gav jag mig på att försöka förklara hur sjutton Generativ AI egentligen funkar och vad olika buzzwords betyder. Tusen tack för alla fina kommentarer och alla delningar som artikeln gav 💖! Betyder mycket.

Du hittar den första artikeln i serien här ➡️ Generativ AI – från ööh? till AHA!

Nu har vi kommit till del 2 av glassmodellen för Generativ AI där vi ska vi prata om de mer kreativa delarna; allt spännande vi kan göra med glasstruten som grund. Lite färre tekniska begrepp i den här alltså, HURRA.

Först behöver vi dock köra en kort repis av glasstruten och göra några centrala tillägg.

Snabbrepris

Grunden för att Generativ AI funkar ligger bland annat i de tekniska komponenterna Foundation Models, LLMs, Transformers och Diffusion Models som vi benade ut i förra artikeln. Struten i modellen.

Idag finns det hundratals varianter av glasstrutar – alltså grundmodeller för Generativ AI – ute på marknaden som har tränats upp på MASSOR med data. Några exempel på stora grundmodeller är GPT-4 från Open AI, PaLM2 från Google, LLaMA2 från Meta + Microsoft, Claude 2 från Antropic och Falcon 180B från Technology Innovation Institute (TII).

Här hittar du en rapport som listar 77 stycken grundmodeller och här finns en sökbar databas.

Vad betyder då det här?

Tack vare Foundation Models behöver företag, organisationer och individer – alltså du och jag – som är sugna på att utveckla AI-lösningar inte göra det oerhört svåra grundjobbet själva. (Vilket är tur då det bland annat kräver djup kompetens inom maskininlärning, mattematik och statistik. Det behövs en massa kraftiga datorer, oerhörda mängder data och jättemycket pengar).

Vi kan istället alltså koppla in oss på strutar (intelligenser) som någon annan har utvecklat och använda dessa för att bygga egna smarta appar och digitala lösningar. Jag tänkte hoppa över hur det funkar rent tekniskt, men API:er är ett vanligt sätt att få ditt system att prata med en Foundation Model. Läs mer här, här, här och här.

Tillägg: Ok, det är inte superenkelt att koppla in och justera en grundmodell för att funka på de sätt som man vill – men det är oerhört mycket enklare att utveckla AI-tjänster i framkant idag än tidigare. Och tröskeln för att kunna bygga Generativa AI-grejer har sänkts REJÄLT.

Vad är det då som byggs?

Vad är det då för generativa lösningar som utvecklas med hjälp av grundmodeller? Och vad ska dessa tusentals nya AI-tjänster hjälpa oss med?

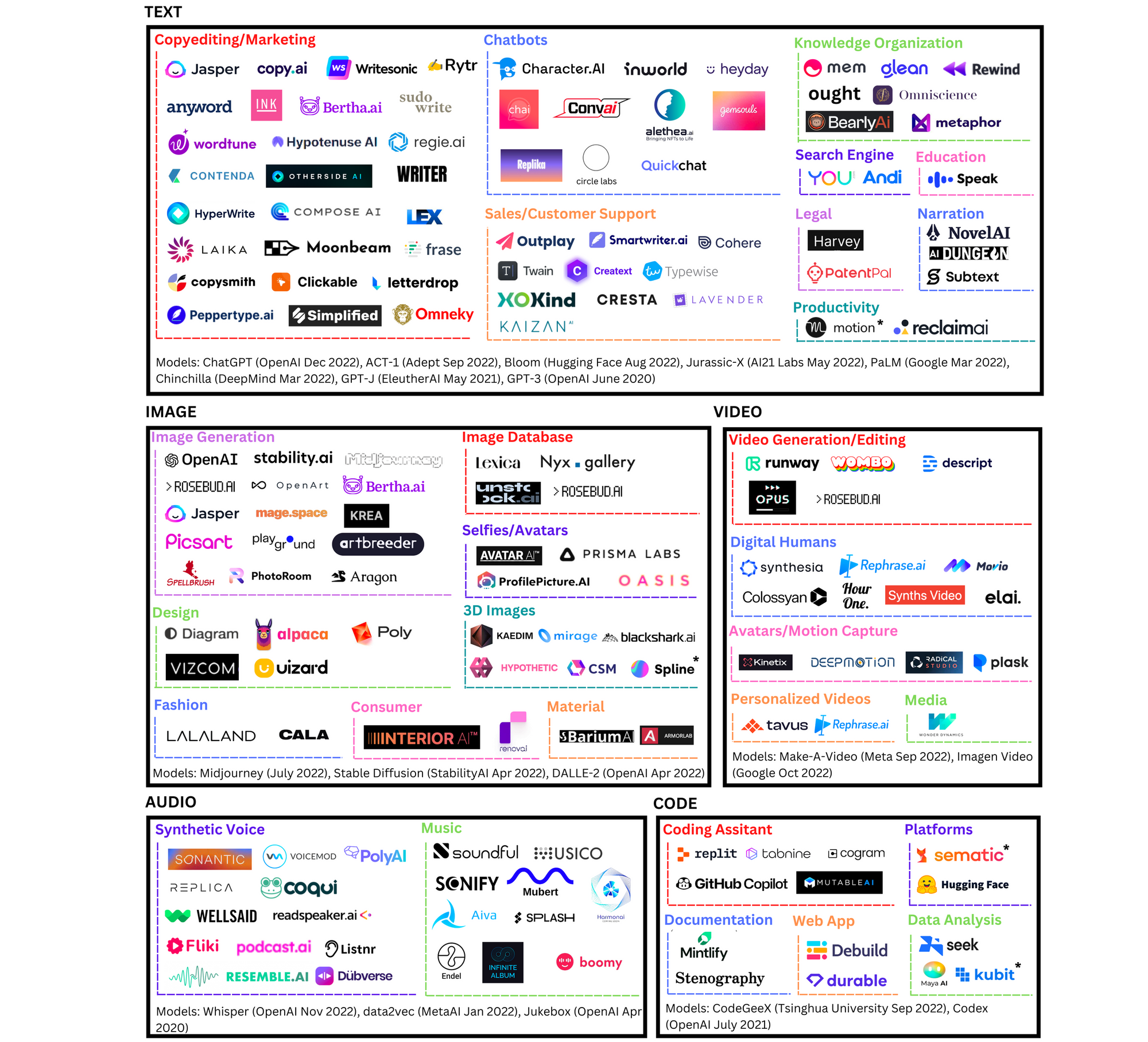

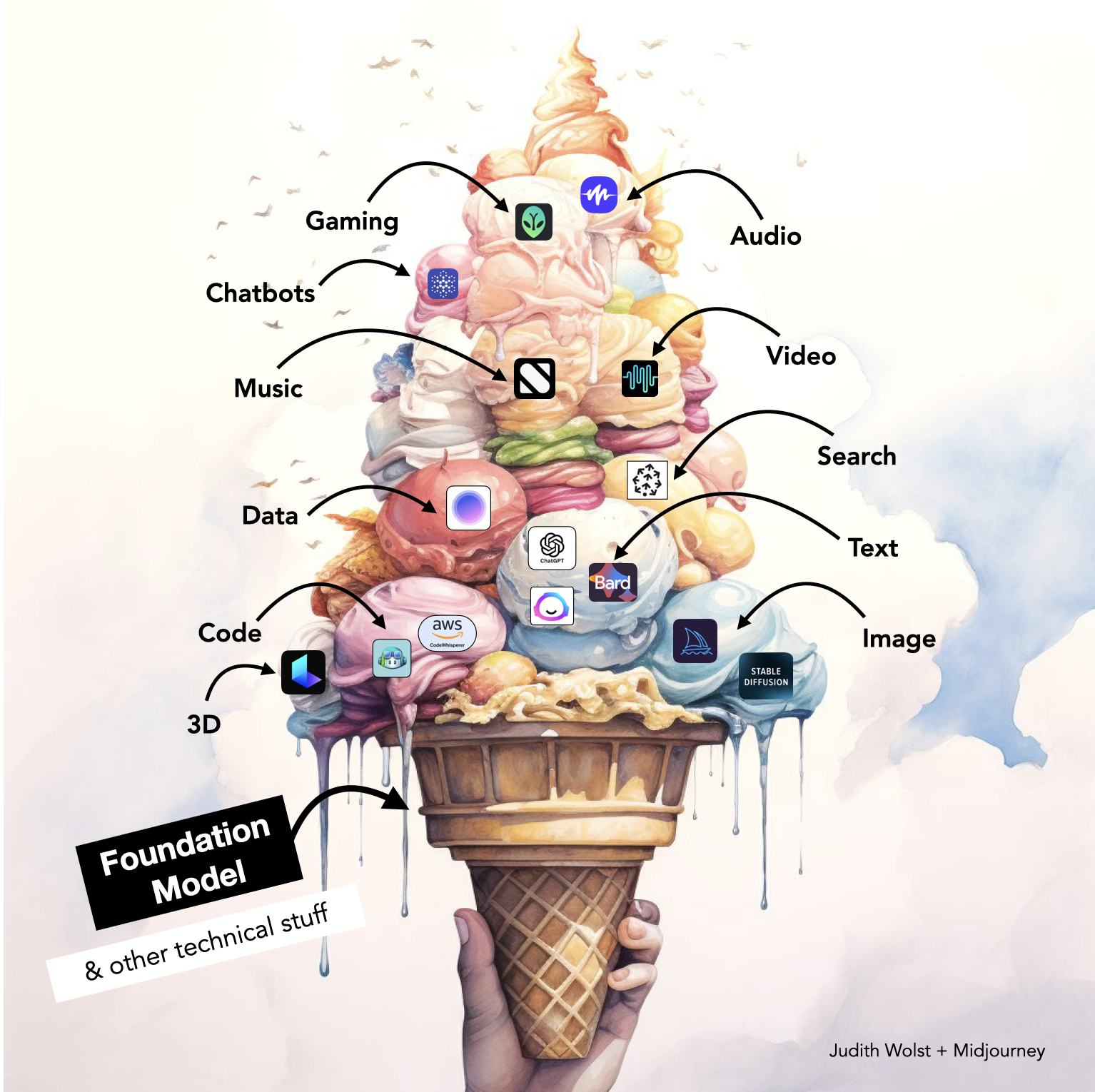

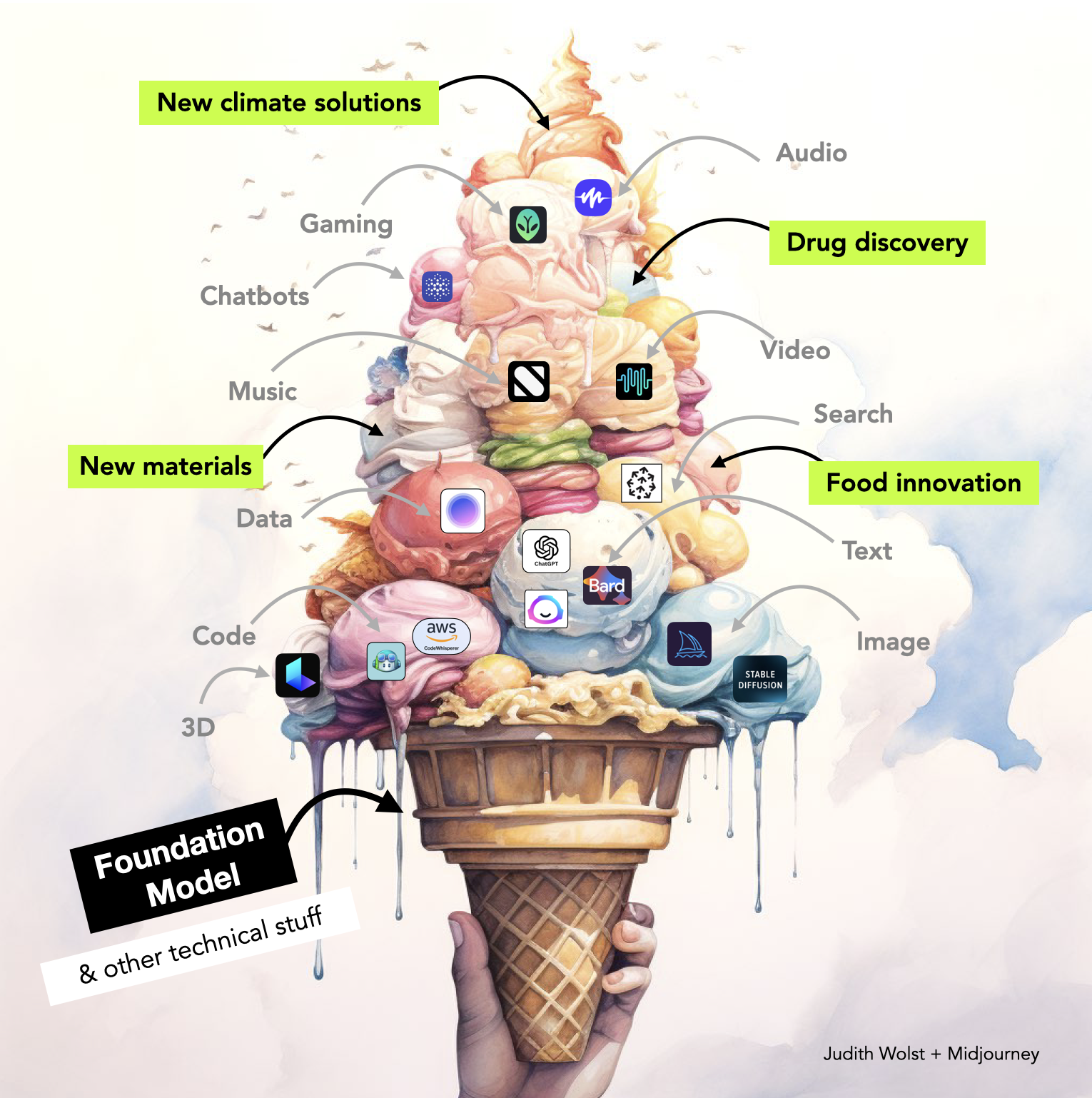

Ett vanligt sätt att kategorisera tillämpningsområden är som i bilden här under; text, images, video, audio, code och så vidare. Inom varje kategori finns det idag oändligt många startups som tävlar om att bli vinnaren i varje respektive område.

I min modell har jag gjort om detta lite inboxade sätt att presentera tillämpningarna till glasskulor – där varje kula representerar ett område där Generativ AI ger oss nya möjligheter ⬇️.

Varje dag, timme och minut lanseras nya Generativa AI-tjänster inom en mängd olika glasskulor. Att som människa hålla koll på allt som händer är därmed en omöjlighet. I mitt huvud brukar jag mentalt se utvecklingen av nya AI-baserade lösningar som ett vattenfall som jag då och då kan besöka för att utforska, testa och lära.

Om du själv vill testa AI-tjänster inom olika typer av områden kommer här några länkar som kan hjälpa dig på vägen.

- Generative AI startups, Dealroom.co – lista över startups utifrån kategorier

- GenAI – plattform som hjälper dig att hitta nya generativa AI-produkter & tjänster

- Antler GenAI Landscape – Antler listar massa AI-baserade tjänster

- AI Library – 1500+ AI tools and colabs

- Generativ AI – konto på LinkedIn med + 1 miljon följare som varje dag postar tips & information om vad som händer inom området

De tjänster som jag själv använder mest i min vardag är följande:

- ChatGPT (version GPT-4) – Min personliga textbaserade assistent som hjälper mig att besvara frågor, få nya perspektiv och bli mer kreativ.

- Midjourney – Bildgenereraren som jag tycker ger det bästa visuella resultatet (och som jag använt för att skapa glassarna i den här artikeln).

- Runway ML – Förvandlar bilder till film, eller skapar rörligt innehåll utifrån din textbaserade prompt.

- ChatPDF – Japp, det är vad det låter. Ladda upp en pdf och chatta med den. Exempelvis kan du be den att sammanfatta sig själv eller förklara sitt innehåll på olika sätt.

- Compose AI - Eftersom jag skriver mycket håller jag just nu på att testa och utvärdera Compose AI (som bland annat är backade av Y Combinator). ”Write faster with AI, save time⚡”.

💬 Kommentera gärna och tipsa om generativa AI-tjänster som du själv har svårt att leva utan. När jag ställde frågan på LinkedIn fick jag bland annat svar från Niclas Deeped Strand som skrev "Jag skulle vilja ha en everything-app för att hålla koll på alla olika AI-applikationer som finns... Det är stört omöjligt att hålla ordning på dem." Och Jesper Åström tipsade om Opus Clip ("repurposes long talking videos into short viral clips") och Clay (”scale your creative outbound ideas).

Fint. Låt oss nu byta fokus en aning.

Generativ AI bortom det förväntade

Det jag har skrivit om så här långt är typiska saker som Generativ AI används till. Men! Med hjälp av struten (Foundation Models & LLM:s) har AI lärt sig att generera en massa andra saker än "bara" innehåll som smarta texter, imponerande bilder och programmerad kod.

Låt oss nu kika på några andra tillämpningar som än så länge levt mer i det dolda.

I glasstruten döljer sig datorers imponerande förståelse för en väldans massa saker, beroende på vilken information som modellerna har tränats på. Förutom att skapa innehåll för internet och hjälpa oss att jobba smartare i vardagen, kan Generativ AI också generera massvis med andra saker. Bland annat det som är markerat med uppiggande skrik-grön färg i bilden här under ⬇️.

Generativ AI lär sig prata naturvetenskap

Förutom att lära sig engelska eller svenska kan glasstrutarna (Foundation Models & LLM:s) lära sig att prata biologi, kemi och andra naturvetenskapliga språk. Låt oss titta på två exempel:

🧪 Fatta molekyler → MoLFormer-XL är en Foundation Model från IBM som har tränats på 1,1 miljarder molekyler och som har lärt sig "the grammar of molecules". Kunskap som kan användas för att påskynda vetenskapliga genombrott. Läs mer här.

"Generative AI could provide an answer, with its ability to create molecules entirely new to nature." - Citat

👩🏻🔬 Greppa hur proteiner är uppbyggda → 2022 lyckats AlphaFold från DeepMind kartlägga alla proteiner i universum som vi människor känner till – närmare bestämt över 200 miljoner stycken. Informationen finns tillgänglig i en databas och är öppen både för forskarvärlden och för kommersiellt bruk på.

När vi tar hjälp av AI för att analysera sådant som vi vet – naturvetenskaplig data kring hur världen runt omkring oss funkar – kan Generativ AI sedan hjälpa oss med sådant som vi inte vet. Genera nya innovationer som kan vara oerhört värdefulla för oss. Redan idag sker det massvis av utveckling inom området. Några konkreta exempel är:

💊 Utveckla nya mediciner → 2019 tog forskare på Massachusetts Institute of Technology (MIT) med hjälp av AI fram en ny typ av antibiotika som kan slå ut resistenta bakterier. Läs mer här och här. Även den här videon från AlphaFold berättar mer om hur man har gett sig på utmaningen med hjälp av AI.

🦠 Accelerera framtagning av vaccin → I flera fall har AI varit involverad vid framtagning av Covid-vaccin. Ett färskt exempel kommer från Oxford University och IBM som med hjälp av AI designat "never-before seen" molekyler som kan blockera SARS-CoV-2, viruset som orsakar Covid-19. Läs mer här.

Innan vi går in på fler konkreta exempel vill jag först prata lite nödvändigt allvar.

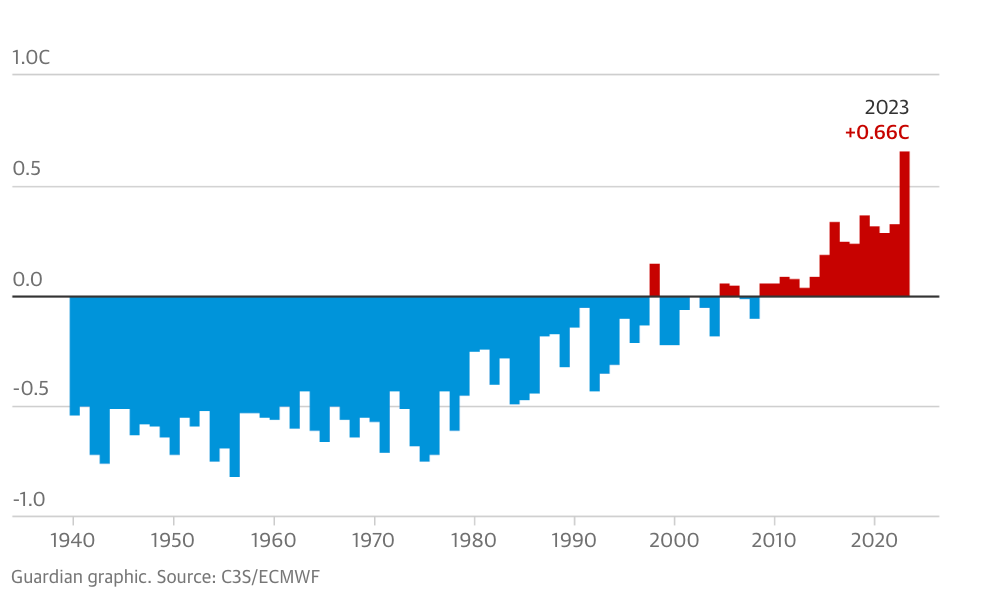

Sommaren 2023 har globalt varit den varmaste någonsin. Det blir allt tydligare att planeten snart inte klarar av att upprätthålla den balans som vi människor fram till nu har tagit för given. Läget kring klimatet är akut. Nyligen belyste FN:s generalsekreterare Antonio Guterres, åter igen, att det är av yttersta vikt att ledare runt om i världen tar klimatkrisen på allra högsta allvar. En kris som ‘is spiralling out of control’ där ‘the climate breakdown has begun’.

Det ÄR fu**ing allvar!

Det borde vara en självklarhet att vår samlade innovationskraft, handlingsförmåga och resursallokering läggs på lösningar som drastiskt hjälper oss att minska utsläppen och skydda naturen. Detta borde vara vår allra största prioritet.

Tillbaks till Generativ AI.

På den positiva sidan kommer smart teknik allt mer att kunna hjälpa oss framåt – bland annat när det kommer till att öka innovationstakten rejält när det kommer till fossilfria och mer hållbara lösningar. Givetvis är teknik aldrig den enda lösningen på våra stora utmaningar. Dock behöver den vara en viktig pusselbit. Det behövs också politisk vilja, ett näringsliv som visar verklig handlingskraft och så vidare.

Vad innebär det här när det kommer till tekniken och AI specifikt?

På samma sätt som Generativ AI kan kläcka fram nya lösningar inom medicinska områden kan vi använda generativ teknik för att utveckla sådant som nya typer av material, livsmedel och gröna innovationer. Låt oss även här titta på några konkreta exempel.

🔋 Utveckla nya typer av batterier → Batterier är idag en viktig komponent för att ställa om 🚗-industrin. Dagens batterier är fortfarande relativt dyra (priset sjunker dock hela tiden) och de kan vara problematiska kopplat till kritiska metaller, ibland konfliktmineraler. Tursamt nog innoverads det just nu rejält inom området, där AI spelar en viktig roll. Chemix är ett USA-baserat bolag som använder Generativ AI för att ta fram nya och bättre batterier som inte innehåller kobolt. Läs mer om just Chemix här. En massa andra liknande exempel finns också.

🔬 Generera nya typer av material → A-Lab är ett initiativ från Lawrence Berkeley National Laboratory (LBNL) som med hjälp av AI har identifierat 150 000 kandidater till nya icke-organiska material. Nya material som exempelvis kan hjälpa oss att utveckla nya sätt att lagra energi, mer effektiva solceller, nya typer av bränsleceller och termoelektriska material (material som genererar energi från temperaturskillnader). Oerhört spännande! Du kan läsa mer i den här artikeln där jag dyker djupare ner i exemplet från A-Lab. På sajten materialsproject.org ligger information om alla nya materialkanidater från labbet samlade.

🍔 Ge hävstång för plantbaserad mat → Kossor är en stor utsläppsbov när det kommer till metangas. Att dra ner på 🐮-baserade produkter – och öka utbudet av växtbaserade alternativ – är en av komponenterna för att få ner utsläppen. Bolaget Climax, en startup som tillverkar vegansk ost, har använt Generativ AI för att hitta den bästa kombinationen av ingredienser för att få till den absolut smaskigaste osten. "The discovery was made possible through precision formulation – a process that uses data science and AI to dramatically increase the speed of discovering optimal ingredient and process combinations with plants." Läs mer här.

🌿 Vill du läsa mer om hoppfulla exempel med AI i centrum har jag skrivit mer om det i den här artikeln.

Σ Summa summarum.

Generativ AI "tänker" och innoverar väldigt annorlunda än våra mänskliga 🧠or. Tillsammans kan människa och maskin – tack vare Generativ AI – nu uppnå rejäl hävstång när det kommer till innovation. Videon här under förklarar mer.

"Did you know that on average, it takes 10 years of research and between $10 million and $100 million to discover and develop a new material? In this video, John R. Smith, IBM Fellow and Discovery Technology Foundations Leader at IBM Research, explores how generative models can reduce these constraints and fuel newer and faster discoveries."

Förutom att öka innovationstakten kan andra typer av AI – alltså inte de generativa varianterna (utan så kallad discriminative AI) – hjälpa oss att optimera och effektivisera sådant som vi redan gör. Som att minska energiförbrukningen i byggnader, skapa en mer pålitlig förnybar energiproduktion, upptäcka och eliminera energiläckage, få till mer intelligent återvinning, minska matsvinn, optimera kollektivtrafiken och så vidare. Allt detta skrev vi på SusTechable om i en AI-rapport som vi släppte i början av 2021. Du kan ladda ner den gratis här (engelsk version finns här).

Avslutningsvis, några rader om satelliter 🛰️

För er som blir extra kittlade av projekt som har med rymden att göra kommer en glädjande avslutande nyhet.

IBM har nämligen i samarbete med NASA släppt en Foundation Model som har tränats på en massa satellitdata. Modellen har lagts upp öppen att använda på AI-plattformen 🤗 Hugging Face. Detta är den största geospatiala grundmodellen på Hugging Face och den allra första grundmodellen som byggts i samarbete med NASA.

"By embracing the principles of open AI and open science, both organizations are actively contributing to the global mission of promoting knowledge sharing and accelerating innovations in addressing critical environmental challenges."

Detta kommer att göra analys av satellitdata mycket enklare och dessutom tillgänglig för alla. Med ytterligare finjusteringar (fine-tuning) kan grundmodellen användas för saker som att hålla koll på avskogning eller mäta utsläpp av växthusgaser. Det ska bli spännande att se allt som kommer att byggas ovanpå denna IBM/NASA-strut! Läs mer här (NASA) och här (IBM).

– 💚 💚 💚 –

Det var allt för den här veckan. & för dig som tagit dig hela vägen hit = TACK! Vi har bara en planet & den håller på att smälta bort. Låt oss tillsammans, på de sätt vi kan, kämpa för att omställningen ska gå betydligt snabbare än idag. Både med och utan smart teknik.

Ta hand om er! & för dig som prenumererar på mina utskick via SubStack så hörs vi igen nästa vecka.

/ Judith

Prenumerera gärna på mitt nyhetsbrev Plötsligt i Framtiden på SubStack där jag en gång i veckan skriver artiklar och sammanställer nyheter inom teknik, hållbarhet och framtid. Det är gratis och kommer utan krav.